컴퓨터 세대 구분: 진공관에서 AI 칩, 그리고 양자까지

내 서버가 왜 이렇게 작고 강력한지 이해하려면, 집채만 했던 1세대 컴퓨터를 봐야 합니다. 하드웨어의 다이어트 역사와 클라우드 비용 절약의 비밀을 파헤칩니다.

내 서버가 왜 이렇게 작고 강력한지 이해하려면, 집채만 했던 1세대 컴퓨터를 봐야 합니다. 하드웨어의 다이어트 역사와 클라우드 비용 절약의 비밀을 파헤칩니다.

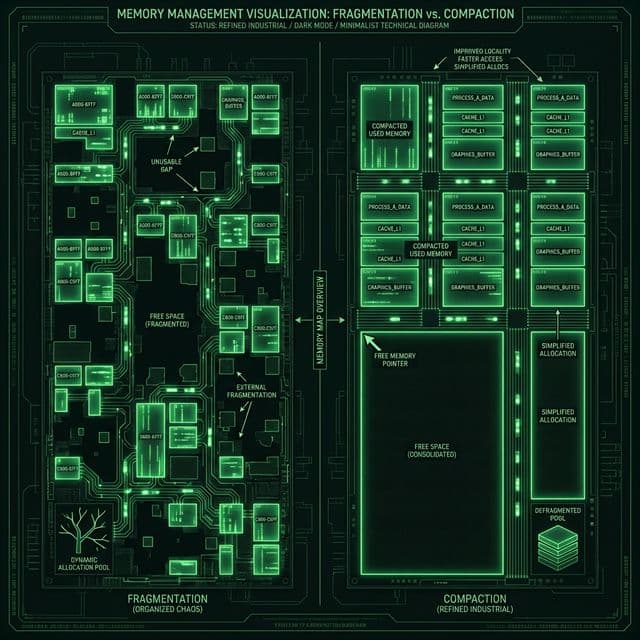

내 서버는 왜 걸핏하면 뻗을까? OS가 한정된 메모리를 쪼개 쓰는 처절한 사투. 단편화(Fragmentation)와의 전쟁.

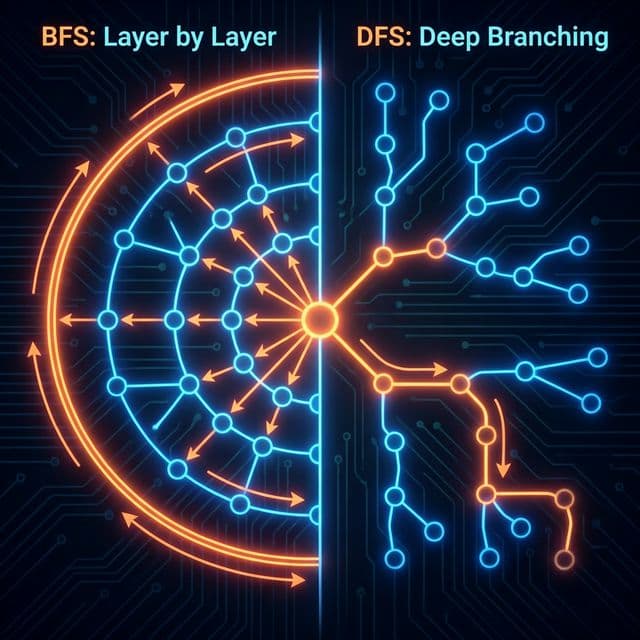

미로를 탈출하는 두 가지 방법. 넓게 퍼져나갈 것인가(BFS), 한 우물만 팔 것인가(DFS). 최단 경로는 누가 찾을까?

이름부터 빠릅니다. 피벗(Pivot)을 기준으로 나누고 또 나누는 분할 정복 알고리즘. 왜 최악엔 느린데도 가장 많이 쓰일까요?

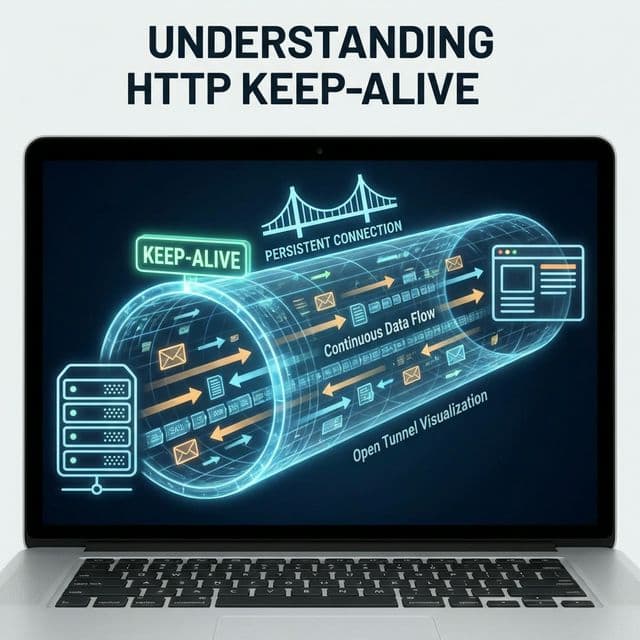

매번 3-Way Handshake 하느라 지쳤나요? 한 번 맺은 인연(TCP 연결)을 소중히 유지하는 법. HTTP 최적화의 기본.

스타벅스에서 노트북 열고 코드 배포하면서 문득 이런 생각이 들었다. 내 맥북은 손바닥만 한데, 이게 어떻게 4K 영상 편집하고 Docker 컨테이너 20개를 동시에 돌리는 거지? 그냥 당연한 줄 알았는데, AWS 인스턴스 타입 고르다가 m5, m6g, m7i 같은 숫자를 보고 궁금해졌다. 이 숫자가 대체 뭘까?

파다 보니 결국 이거였다. 컴퓨터의 역사는 한마디로 "더 작게, 더 차갑게, 더 빠르게"를 향한 70년 투쟁이었다는 걸 이해했다.

집채만 했던 괴물이 내 주머니 속으로 들어오기까지, 그 진화 과정을 정리해본다. 이거 알면 클라우드 비용 20% 절약하는 눈이 생긴다. 진짜다.

컴퓨터를 1세대, 2세대로 나누는 게 처음엔 좀 우습게 느껴졌다. "그냥 점점 좋아진 거 아냐?" 싶었는데, 깊이 파보니 각 세대마다 근본적으로 다른 물질로 스위치를 만들었다는 걸 와닿았다.

컴퓨터의 본질은 결국 스위치다. 0과 1을 껐다 켰다 하는 장치. 이 스위치를 "무엇으로 만들었느냐"가 세대를 가른다. 유리관으로 만들면 1세대, 반도체로 만들면 2세대, 집적회로로 찍어내면 3세대. 이게 단순한 개선이 아니라 패러다임의 전환이었다.

비유하자면, 자전거에서 자동차로 바뀐 게 아니라 말에서 증기기관차로, 증기기관차에서 전기차로 바뀐 것과 같다. 동력 자체가 바뀌는 거다.

대학교 때 박물관에서 ENIAC 사진을 봤다. 체육관 하나를 꽉 채운 괴물. 무게 30톤, 진공관 18,000개. 이게 컴퓨터라고? 지금 내 손에 든 아이폰이 ENIAC보다 100만 배 빠르다는 걸 나중에 알고 정말 어이가 없었다.

스위치 재료: 진공관 (Vacuum Tubes) - 백열전구처럼 생긴 유리관 대표 기계: ENIAC 특징: 전구처럼 뜨겁고, 전구처럼 잘 터짐

1세대 컴퓨터는 그야말로 열과의 전쟁이었다. 진공관은 필라멘트를 달궈서 작동하는 원리라, 엄청나게 뜨거웠다. 전설에 따르면 ENIAC을 켜는 순간 필라델피아 시내 가로등이 깜빡거렸다고 한다. (150kW를 퍼먹었다. 지금 가정용 전기의 약 100배다.)

더 큰 문제는 내구성. 진공관이 전구처럼 수시로 터졌다. 엔지니어들은 계산시키는 시간보다 터진 진공관 찾아서 갈아 끼우는 시간이 더 길었다. MTBF(Mean Time Between Failures)가 몇 시간 단위였다.

상상해 보라. 코드 돌리는데 3시간마다 서버가 다운되고, 데이터센터 직원이 18,000개 중 어느 부품이 고장났는지 일일이 체크해야 한다면? 지금 같았으면 그냥 회사 접었을 것이다.

Grace Hopper의 전설: 1947년, 하버드 Mark II 컴퓨터가 오작동했다. 원인을 찾아보니 진짜 나방(moth)이 릴레이에 끼어 있었다. 그레이스 호퍼 박사가 이걸 테이프에 붙여서 로그북에 기록했고, 이게 소프트웨어 "버그(Bug)"의 유래가 되었다. 지금 우리가 "버그 잡는다"고 말할 때, 그 기원은 진짜 벌레였던 셈이다.

진공관 시대의 교훈은 명확했다. 열 = 돈 = 고장. 더 차가운 스위치가 필요했다.

1947년, 벨 연구소(Bell Labs)의 윌리엄 쇼클리, 존 바딘, 월터 브래튼이 트랜지스터를 발명했다. 이 세 사람은 나중에 노벨상을 받는다. 그럴 만했다. 인류 역사상 가장 중요한 발명품 중 하나니까.

스위치 재료: 트랜지스터 (Transistor) - 실리콘/게르마늄 반도체 혁신 포인트: 고체 소자 (Solid State) - 터지지 않는다! 크기: 진공관의 1/100

트랜지스터는 유리관 대신 반도체 결정체를 쓴다. 열을 내지 않고, 터지지 않고, 크기는 100분의 1. 게임 체인저였다.

컴퓨터가 체육관에서 벗어나 "큰 냉장고" 크기로 줄어들었다. 여전히 컸지만, 적어도 건물을 통째로 쓰진 않았다. IBM이 이 시기에 메인프레임으로 돈방석에 앉았다.

이때부터 고급 프로그래밍 언어가 등장한다.

C FORTRAN 77 - 2세대 컴퓨터에서 돌아간 최초의 고급 언어

PROGRAM HELLO

PRINT *, 'Hello, World!'

END

* COBOL - 은행 시스템이 아직도 이걸 쓴다

IDENTIFICATION DIVISION.

PROGRAM-ID. HELLO.

PROCEDURE DIVISION.

DISPLAY 'Hello, World!'.

STOP RUN.

받아들였다. 이 시점부터 프로그래머와 하드웨어 엔지니어가 분리되기 시작했다는 걸. 진공관 갈 필요 없이 코드만 짜면 됐으니까.

트랜지스터는 작고 좋았지만, 여전히 하나하나 납땜해야 했다. 1960년대 초, 텍사스 인스트루먼트의 잭 킬비와 페어차일드의 로버트 노이스가 거의 동시에 같은 아이디어를 냈다.

"그냥 실리콘 웨이퍼 위에 회로를 사진 인화하듯이 찍어내면 안 돼?"

집적회로(Integrated Circuit, IC) 탄생. 작은 칩 하나에 트랜지스터 수천 개를 때려 박았다.

스위치 재료: 실리콘 칩 위에 식각(Etching)된 회로 혁신: 대량생산 가능, 신뢰성 폭증 키워드: 포토리소그래피(Photolithography)

이제 컴퓨터는 책상 위에 올라갔다. 키보드와 모니터가 등장하고, 운영체제(OS)의 개념이 생겼다. 우리가 아는 컴퓨터의 모습을 갖추기 시작했다.

비유하자면, 수공예 시대에서 공장 자동화로 넘어간 것과 같다. 자동차를 장인이 하나씩 만들던 시대에서, 컨베이어 벨트로 대량생산하는 시대로 바뀐 거다.

1971년, 인텔이 4004라는 최초의 마이크로프로세서를 만들었다. 크기는 손톱만 했지만, 그 안에 컴퓨터의 모든 두뇌가 들어갔다.

스위치 재료: LSI/VLSI (Large Scale Integration / Very Large Scale Integration) 트랜지스터 수: 수천 → 수백만 → 수십억 개 대표 칩: Intel 4004, 8086, Pentium, i9, Apple M3, AMD Ryzen

이 시점부터 무어의 법칙(Moore's Law)이 작동하기 시작했다.

무어의 법칙: "반도체 집적도는 18~24개월마다 2배로 증가한다."

인텔 공동창업자 고든 무어가 1965년에 예측한 이 법칙은 50년간 현실이 되었다. 기하급수적 성장. 2년마다 2배씩 50년이면... 계산해 보면 약 10억 배다. 실제로 그랬다.

# 무어의 법칙 시뮬레이션

def moores_law(years, initial_transistors=2300):

"""Intel 4004(1971)부터 현재까지"""

transistor_count = initial_transistors

doubling_period = 2 # years

for year in range(0, years, doubling_period):

print(f"Year {year}: {transistor_count:,.0f} transistors")

transistor_count *= 2

return transistor_count

# 1971년(Intel 4004)부터 2024년까지 53년

final_count = moores_law(53)

# 결과 - 약 5,000억 개 (실제 M3 Pro: 370억 개 트랜지스터)

하지만 지금은 한계에 부딪혔다. 트랜지스터가 원자 수십 개 크기까지 작아지면서 양자 터널링(전자가 벽을 뚫고 새어나가는 현상)이 발생한다. 더 이상 작게 만들 수 없는 물리적 벽이다.

그래서 전략이 바뀌었다. "더 작게"가 아니라 "더 특화되게".

스타트업 초기에 ML 모델 학습시키려고 AWS p3 인스턴스(GPU 달린 서버)를 썼다. 같은 작업을 일반 CPU로 하면 3일 걸리는데, GPU로 하니 6시간 만에 끝났다. 비용은? GPU가 더 쌌다.

그 순간 와닿았다. 범용 프로세서로 모든 걸 하는 시대는 끝났구나.

5세대의 핵심: 특정 작업에 극한으로 최적화된 칩들

원래 GPU는 게임용이었다. 화면에 픽셀 뿌리는 단순 작업을 수천 개 코어로 병렬 처리하는 칩. 근데 누가 생각했다. "어? 이거 행렬 곱셈 하는 데 쓰면 좋겠는데?"

NVIDIA CUDA가 나오면서 GPU가 AI 학습의 일등 공신이 되었다.

# CPU vs GPU 성능 비교 (간단한 벤치마크)

import time

import numpy as np

# CPU 행렬 곱셈

def cpu_matrix_multiply(size=5000):

a = np.random.rand(size, size)

b = np.random.rand(size, size)

start = time.time()

c = np.dot(a, b) # CPU로 연산

return time.time() - start

# GPU 행렬 곱셈 (PyTorch 예시)

import torch

def gpu_matrix_multiply(size=5000):

a = torch.rand(size, size).cuda()

b = torch.rand(size, size).cuda()

start = time.time()

c = torch.matmul(a, b) # GPU로 연산

torch.cuda.synchronize()

return time.time() - start

# 결과 - GPU가 10~100배 빠름

비유하자면, 우편 배달부 1명 vs 오토바이 택배 100명의 차이다. CPU는 똑똑한 배달부 한 명이 순서대로 배달하고, GPU는 단순한 오토바이 100대가 동시에 뿌린다.

ASIC (Application-Specific Integrated Circuit): 특정 목적을 위해 태어난 칩

속도는 압도적이지만, 유연성은 제로다. 채굴기로 게임은 못 돌린다.

FPGA (Field-Programmable Gate Array): 하드웨어 회로를 소프트웨어처럼 다시 짤 수 있는 칩

// FPGA 프로그래밍 예시 (Verilog HDL)

module led_blinker(

input wire clk,

output reg led

);

reg [24:0] counter;

always @(posedge clk) begin

counter <= counter + 1;

if (counter == 0)

led <= ~led; // LED 깜빡임

end

endmodule

하드웨어의 속도 + 소프트웨어의 유연성. 통신장비, 방산, 금융 HFT(초고속 매매)에 쓰인다.

비유하자면, 조립식 레고 블록이다. CPU는 완성된 장난감, ASIC은 접착제로 고정된 피규어, FPGA는 언제든 다시 조립할 수 있는 레고.

최신 스마트폰(아이폰 15, 갤럭시 S24)에는 NPU (Neural Processing Unit)가 들어있다. 인간 뇌신경을 모방한 뉴로모픽 칩.

온디바이스 AI가 가능해진 이유다. Siri가 네트워크 없이 작동하고, 실시간 번역이 되는 이유.

IBM Quantum, Google Sycamore 같은 양자 컴퓨터는 큐비트(Qubit)를 쓴다. 0과 1이 중첩(Superposition)된 상태를 이용한다.

아직 실용화는 멀었지만, 현재 암호체계(RSA)를 깨뜨릴 가능성 때문에 전 세계가 주목하고 있다.

정리해본다. 5세대는 "만능 스위스 아미 나이프" 대신 "각자 잘하는 전문 도구"를 쓰는 시대다.

AWS를 처음 쓰다 보면 첫 달 청구서가 예상보다 훨씬 많이 나오는 경우가 생긴다. 뭐가 문제지?

인스턴스 타입을 보면 m5.xlarge를 쓰고 있는 경우가 많다. "m이 뭐지? 5가 뭐지?" 찾아보니 5세대 칩이라는 뜻이었다.

# AWS EC2 인스턴스 타입 명명 규칙

# [인스턴스 패밀리][세대][추가 기능].[크기]

# 예시:

# m5.xlarge → 5세대, 인텔 Xeon

# m6g.xlarge → 6세대, ARM Graviton2

# m7i.xlarge → 7세대, 인텔 Ice Lake

# m7g.xlarge → 7세대, ARM Graviton3

# 가격 비교 (us-east-1 기준, 2024년)

aws ec2 describe-instance-types \

--instance-types m5.xlarge m6g.xlarge m7g.xlarge \

--query 'InstanceTypes[*].[InstanceType, VCpuInfo.DefaultVCpus]' \

--output table

| 인스턴스 타입 | vCPU | 시간당 가격 | 월 비용 (730시간) |

|---|---|---|---|

| m5.xlarge | 4 | $0.192 | $140.16 |

| m6g.xlarge | 4 | $0.154 | $112.42 |

| m7g.xlarge | 4 | $0.162 | $118.26 |

깨달음: 같은 스펙인데 m6g(ARM)가 20% 쌌다.

컴퓨터 역사를 알면 답이 보인다.

전력 효율 향상: 공정이 미세화될수록 전기를 덜 먹는다.

발열 감소: 데이터센터 냉각비용 절감

ARM의 부상: 모바일에서 검증된 전성비

# 실제 비용 절감 계산

def calculate_savings(current_instance, hours_per_month=730):

prices = {

'm5.xlarge': 0.192,

'm6g.xlarge': 0.154,

'm7g.xlarge': 0.162

}

current_cost = prices[current_instance] * hours_per_month

print(f"현재 인스턴스: {current_instance}")

print(f"월 비용: ${current_cost:.2f}")

print("\n최적화 옵션:")

for instance, price in prices.items():

if instance != current_instance:

new_cost = price * hours_per_month

savings = current_cost - new_cost

percent = (savings / current_cost) * 100

print(f" {instance}: ${new_cost:.2f} (월 ${savings:.2f} 절감, {percent:.1f}%)")

calculate_savings('m5.xlarge')

# 출력:

# 현재 인스턴스: m5.xlarge

# 월 비용: $140.16

#

# 최적화 옵션:

# m6g.xlarge: $112.42 (월 $27.74 절감, 19.8%)

# m7g.xlarge: $118.26 (월 $21.90 절감, 15.6%)

#!/bin/bash

# ARM(Graviton) 마이그레이션 가능 여부 체크

echo "1. Docker 이미지 아키텍처 확인"

docker manifest inspect nginx:latest | jq '.manifests[] | .platform'

echo "2. 의존성 패키지 ARM 지원 여부"

dpkg --print-architecture # amd64 → arm64 확인

echo "3. 성능 벤치마크 비교"

# x86과 ARM에서 동일한 워크로드 실행

sysbench cpu --cpu-max-prime=20000 run

echo "4. 호환성 테스트"

# 특정 라이브러리(예 - 오래된 네이티브 바이너리)는 ARM 미지원 가능

ldd /usr/local/bin/your-binary

실제 사례: Node.js 앱을 m5에서 m6g로 옮기면 코드 수정 없이 월 비용을 크게 절약할 수 있다. AMI만 ARM용으로 바꾸는 것만으로도 된다.

전 세계 데이터센터가 소비하는 전력: 전 세계 전기의 2-3%. 항공 산업보다 탄소를 더 많이 배출한다.

무한루프 하나가 서버 하나를 100% 돌리고, 그 서버를 식히려고 에어컨이 돌고, 발전소가 석탄을 태운다. 비효율적인 코드는 환경 파괴다.

# 나쁜 예 - O(n^2) 알고리즘

def bad_search(items, target):

for i in items:

for j in items: # 중첩 루프

if i == j == target:

return True

return False

# 좋은 예 - O(n) 알고리즘

def good_search(items, target):

return target in set(items) # 해시 테이블 사용

import time

items = list(range(10000))

start = time.time()

bad_search(items, 9999)

bad_time = time.time() - start

start = time.time()

good_search(items, 9999)

good_time = time.time() - start

print(f"나쁜 코드: {bad_time:.4f}초")

print(f"좋은 코드: {good_time:.6f}초")

print(f"에너지 절약: {(bad_time/good_time):.0f}배")

# 출력 - 에너지 절약: 10000배

PUE (Power Usage Effectiveness): 데이터센터 효율 지표

이젠 "빠른 코드"가 곧 "친환경 코드"다.

진공관 → 트랜지스터 → IC → LSI로 올수록, 크기는 줄고 성능은 올랐다. 여기서 중요한 건 발열이다.

열 = 에너지 낭비 = 돈클라우드 인스턴스를 고를 때, 최신 세대 + ARM을 선택하는 이유는 단순하다. 발열이 적어서 클라우드 사업자가 냉각비를 아끼니까 가격을 깎아주는 것이다.

CPU로 모든 걸 하는 시대는 끝났다. ML 학습은 GPU, 추론은 NPU/TPU, 영상 인코딩은 전용 칩(H.264 encoder). 각자 잘하는 걸 시킨다.

비유하자면, 미슐랭 셰프 1명에게 100인분 요리를 시키는 것보다, 전문 주방 팀(볶음 전담, 구이 전담, 디저트 전담)을 쓰는 게 낫다는 것과 같다.

무어의 법칙이 끝났다는 건, "더 작게"가 한계라는 뜻이다. 그럼 다음은? "더 특화되게", "더 병렬로", "더 차갑게"다.

이런 흐름을 알면 어떤 기술에 투자해야 할지, 어떤 아키텍처를 선택해야 할지 보인다.

진공관 18,000개를 관리하던 1세대 엔지니어들은 상상이나 했을까? 자신들이 땀 흘리며 교체하던 그 뜨거운 유리관 100억 개가 지금 내 주머니 속 차가운 금속 칩 안에 들어있다는 사실을.

우리는 거인들이 쌓아 올린 이 엄청난 기술의 탑 위에서 아주 편하게 코딩하고 있다. npm install 한 줄로 수많은 라이브러리를 가져오고, 클릭 몇 번으로 슈퍼컴퓨터를 빌려 쓴다.

가끔 코드가 꼬여서 짜증 날 때, 잠시 모니터 뒤의 칩을 생각해 본다. 전구만 한 진공관을 원자 단위로 압축해 준 선배 엔지니어들의 집념에 경의를 표하며, 다시 버그를 잡으러 간다.

우리는 적어도 진공관 갈아 끼울 필요는 없잖아? (아, 근데 가끔 서버 재부팅은 해야 하지만...)

결국 이거였다: 컴퓨터의 역사는 열과 크기와의 싸움이었고, 그 싸움에서 이긴 자가 세상을 지배했다. 지금 클라우드 비용을 절약하고 싶다면, 이 원칙을 기억하면 된다. 더 작고, 더 차갑고, 더 새로운 것을 고르면 이긴다.